Imagem: Istock

Smart Sampa

O programa 'Smart Sampa', projeto de videomonitoramento e reconhecimento facial para a segurança pública da cidade de São Paulo, vem dividindo opiniões. Idealizado pela gestão Ricardo Nunes (MDB), o edital prevê a instalação de 20 mil câmeras pela capital, com o intuito de armazenar informações do sistema de reconhecimento facial em cruzamento com a localização dos indivíduos. A meta é instalar 2,5 mil câmeras na região central, e também no entorno de escolas, parques, unidades de saúde e locais com grande movimentação. A previsão é integrar o monitoramento na cidade até o ano de 2024, com um investimento estimado de 70 milhões por ano.

Histórico

A primeira versão do edital foi publicada em novembro de 2022, e alegava que "a pesquisa deve ser feita por diferentes tipos de características como cor, face e outras características", e também afirmava que "a previsão de que a identificação do comportamento ocorra com base em situações de ‘vadiagem’ e ‘tempo de permanência’ do suspeito em um local."

Entidades como o IDEC (Instituto Brasileiro de Defesa ao Consumidor) e outras 50 organizações se manifestaram contra, e após críticas, a prefeitura decidiu suspender o pregão para a contratação do sistema, a fim de suprimir as possíveis dúvidas sobre a gestão do programa. “A gestão municipal entende que a tecnologia pode e deve ser empregada também nas políticas de segurança pública preventiva, desde que corrigindo erros anteriores, respeitando as leis e os direitos individuais”, apontou o prefeito.

Depois de quatro meses em suspensão, no mês de abril de 2023, o conteúdo do edital foi parcialmente modificado e o Tribunal de Contas do Município (TCM) liberou a retomada para a compra das câmeras. No dia 18 de maio, o pregão foi novamente suspenso por uma liminar do juiz Luis Manuel Fonseca Pires, que considerou a possibilidade de ameaça aos dados pessoais dos indivíduos, o que poderia violar a Lei Geral de Proteção de Dados (LGPD). Além disso, Fonseca salientou a quantidade de especialistas e estudiosos que preveem o risco de reprodução do racismo estrutural no uso do sistema.

Alguns dias depois, 23 de maio, a prefeitura de São Paulo e a Secretaria de Segurança Urbana conseguiram derrubar o embargo ao projeto, através de uma liminar da desembargadora Paola Lorena, do Tribunal de Justiça de São Paulo (TJSP) , que alegou que “não há evidência de que a implementação de videomonitoramento reforce eventual discriminação social e racial, considerando que, com relação a artigos e matérias jornalísticas, não é possível analisar como foram produzidos ou, ainda, se os autores e suas conclusões são independentes e imparciais”. Realizado na última segunda-feira (29), o pregão eletrônico contou com a participação de 12 empresas interessadas em fornecer o sistema de videomonitoramento para a prefeitura da capital. A melhor proposta apresentada foi de 9,2 milhões por mês para a implementação do serviço, com todos os requisitos exigidos no edital. Caso a oferta seja confirmada, a empresa vencedora deve faturar em média 552 milhões de reais ao longo de 60 meses.

Racismo estrutural

O uso de tecnologias com reconhecimento facial já é uma realidade em muitos países. O Brasil ocupa o quinto lugar na lista de países com mais redes de câmeras utilizadas para a vigilância e com a tecnologia de inteligência artificial, segundo o Índice Global de Vigilância de Direitos Digitais. No entanto, esse sistema é questionado por muitos especialistas e as controvérsias são cada vez mais latentes na sociedade.

O Panóptico, projeto do Centro de Estudos de Segurança e Cidadania (CESeC), tem como objetivo monitorar o reconhecimento facial no Brasil. O mapa que registra os casos em andamento, finalizados ou em teste no país, identifica que cidades em 23 estados brasileiros já possuem ou estão aderindo a algum projeto de videomonitoramento para a segurança pública.

Os estudos do centro de pesquisa revelam que, em 2018, cerca de 90% das pessoas presas com a tecnologia utilizada no Rio de Janeiro eram negras. Pablo de Moura Nunes de Oliveira, coordenador adjunto do CESeC e doutor em ciência política pela UERJ, afirma que "Esses algoritmos erram muito, e erram principalmente com pessoas negras, notoriamente mulheres negras. Pelo paper publicado chamado Gender Shades, avaliou exatamente que os homens brancos possuem 34% mais chances de serem reconhecidos de maneira correta do que mulheres negras."

Pablo ainda complementa que o cenário do Brasil não contribui para o sucesso do sistema, ignorando os problemas estruturais do país. "Além disso, nós utilizamos aqui no Brasil essa tecnologia em uma sociedade que está estruturada, o seu sistema de justiça criminal, no racismo."

As taxas de erro são uma grande preocupação. Em um contexto global, mesmo com avanços, aprimoramentos e melhora nas tecnologias de inteligência artificial, a Universidade de Essex apontou que a porcentagem de erro do sistema utilizado pela polícia de Londres chegou a 81%. A pesquisa apresentou a necessidade de uma atenção em relação ao uso dessas tecnologias, além da falta de precisão e falhas que o sistema apresenta. Rafael Alcadipani, professor titular da Fundação Getúlio Vargas e associado pleno ao Fórum Brasileiro de Segurança Pública, comenta que são necessárias soluções inovadoras para a gestão da área, no entanto é fundamental que "as soluções funcionem, mas funcionem de forma a não gerar mais problemas em um país tão racista quanto o nosso."

Pablo enfatizou um caso de erro no reconhecimento facial que aconteceu no Rio de Janeiro, quando uma mulher foi identificada erroneamente e a pessoa suspeita já estava presa há quatro anos, "mostrando exatamente que o banco de dados utilizado era desatualizado, e deixando bem claro que as força de segurança pública não estão capacitadas e não tem responsabilidade para lidar com tamanho risco" - comentou.

O município garantiu que o sistema será rígido e diferente de outras cidades, aderindo um protocolo que considera detecções com apenas 90% de paridade no reconhecimento facial. Além disso, é frizado que todos os alertas serão devidamente investigados por profissionais capacitados. Durante o evento LIDE, na capital, o prefeito Ricardo Nunes defendeu o programa e afirmou que "Estão criando uma polêmica em algo que a gente já construiu, um sistema que muitas cidades já desenvolvem, que no metrô tem, em vários locais tem, é como se fosse algo muito inovador e na verdade estamos atrasados. São Paulo está correndo atrás de um prejuízo.

Lei Geral de Proteção de Dados

Especialistas também chamam atenção para uma possível transgressão da Lei Geral de Proteção de Dados (LGPD) na utilização das câmeras. Quando suspendido pelo TJSP, uma das fortes alegações envolveu o fato de que "O edital não é claro a respeito do processamento de dados, o que poderia levar à exposição de informações sigilosas da população e ferir a lei".

A LGPD entrou em vigor em setembro de 2022, no entanto existe um vácuo na lei, afirmando que as suas regulamentações e parâmetros não se encaixam no que diz respeito à segurança pública.

Em entrevista para reportagem do O Panóptico, O coordenador de políticas e pesquisador do Instituto de Referência em Internet e Sociedade (IRIS-BH), Gustavo Rodrigues, afirmou que “No caso brasileiro, há uma peculiaridade porque o desenho da nossa Lei Geral de Proteção de Dados é muito inspirado no desenho da lei Europeia, a GDPR. Só que na Europa, eles promulgaram a GDPR e logo já promulgaram uma lei sobre o tratamento de dados para os fins dessas exceções, de segurança pública, etc. Aqui no Brasil, não. Nós passamos a LGPD, mas essa outra lei ficou para depois”

Alcadipani pontua sobre a necessidade de rigor e clareza: "É importante que você tenha total de como esses dados vão ser armazenados, como esses dados vão ser utilizados, isso é fundamental acontecer para que a gente tenha uma implementação que seja a contento e funcione de forma adequada."

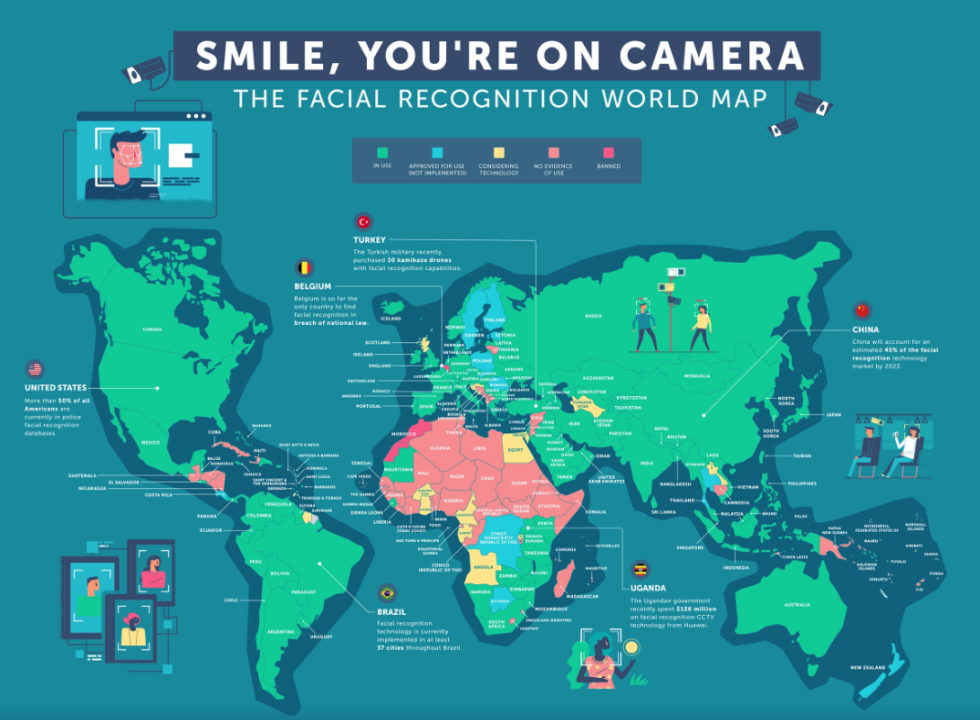

As câmeras pelo mundo

Atualmente, é possível dizer que a maioria dos países utilizam o sistema de reconhecimento facial de alguma maneira, de forma institucionalizada. Ainda não existem estudos e pesquisas que realmente comprovem os benefícios da tecnologia, no entanto é comum ver a expansão das câmeras em um contexto global.

Na Europa, a taxa de erro do sistema foi de 96% dos casos, apontando que a maioria dos suspeitos são, na realidade, inocentes. Em artigo, Lucas Cortizo, advogado e especialista em direito digital, questiona "Se para prender um culpado, o Estado precisa monitorar cada passo de vários inocentes, até que ponto a vigilância vai causar um sentimento de segurança?".

Já na Rússia, o uso da IA ficou conhecido por mapear as vítimas de COVID-19 e analisar a movimentação de cada um dos infectados pelo vírus, averiguando o cumprimento das regras de quarentena. Em territórios belgas e marroquinos o uso da tecnologia de reconhecimento facial foi banido, uma vez que os países entenderam que a implementação poderia violar direitos e ser nociva à população.

O modelo estadunidense de cultuar um policiamento preditivo, é potencializado pelo uso das câmeras na segurança pública. Esse modelo possui como pressuposto a utilização e coleta de dados de diversas fontes para antecipar um crime, ou seja, prevenir e tomar medidas com base em um possível crime no futuro. São Francisco foi a primeira cidade no país a banir o uso da tecnologia para o serviço público, alegando que "A propensão da tecnologia de reconhecimento facial a colocar em perigo os direitos e as liberdades civis supera substancialmente seus benefícios. Além de "exacerbar a injustiça racial e ameaçar nossa capacidade de viver sem a contínua vigilância do governo".